Обзор методов ускорения нейронных сетей от Xilinx

Компания Xilinx уже не первый год развивает собственную экосистему, которая позволяет использовать её ПЛИС и SoC для ускорения работы нейронных сетей. Это и интеграция поддержки сетей в собственные продукты, и адаптация существующих сетей к имеющимся аппаратным платформам. У Xilinx имеется большой банк библиотек нейронных сетей «Model Zoo», в котором содержатся уже обученные и адаптированные для применения на ПЛИС и SoC сети. Это позволяет существенно упростить развёртывание и применение сетей в самых разных устройствах.

Документ содержит следующие разделы:

- Introduction

- A Quick Introduction to Deep Neural Networks

- Trends in DNN Models for Inference

- Methods for Creating More Efficient DNNs

- Efficient Topologies

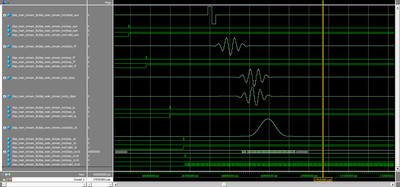

- Pruning

- Layer Fusion and Decomposition

- Accuracy-Computation Trade-Offs: Examples from Quantization

- Trends in Inference Accelerator Architectures

- The Landscape of Inference Accelerator Architectures

- FPGA Implementation Advantages for Efficient DNNs

- Summary

- References