FPGA or GPU: Which One For Machine Learning Applications?

В наши дни много шума вокруг использования FPGA в качестве альтернативы графическим процессорам для машинного обучения. Но как их сравнить? Есть ли между ними какие-то принципиальные различия, или некоторые люди просто преувеличивают значимость этой темы?

В этой статье будет представлено немного информации о каждой технологии, а затем мы углубимся в варианты их использования, чтобы увидеть и сравнить их плюсы и минусы. Давайте начнем с пересмотра того, что такое машинное обучение.

В двух словах, машинное обучение — это способ научить компьютеры учиться без явного программирования. Компьютеры учат изучать закономерности из данных, выявлять тенденции и делать прогнозы.

Это технология, система обучения, основанная на алгоритме, который делает возможным ИИ, предоставляя формулу, которая сообщает системе, как решать конкретные проблемы, или просматривая исторические данные.

ИИ, машинное обучение и глубокое обучение — это одно и то же?

Машинное обучение является одновременно подмножеством искусственного интеллекта (ИИ) и методом, используемым в ИИ, который направлен на то, чтобы сделать компьютеры умнее. Глубокое обучение, тем временем, является подмножеством машинного обучения, целью которого является предоставление компьютерам когнитивных способностей, подобных человеческим, таких как распознавание объектов и языковой перевод.

Когда дело доходит до приложений в области машинного обучения, наиболее популярным вариантом является использование графического процессора, специально разработанного для выполнения параллельных вычислений данных.

Но что, если вместо этого вы хотите реализовать свой алгоритм на FPGA?

У каждого подхода есть свои плюсы и минусы, которые делают их жизнеспособными альтернативами в зависимости от ваших потребностей в реализации. Вот как они складываются друг против друга.

GPU VS FPGA in Machine Learning Application

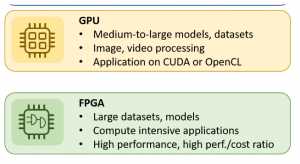

Графический процессор или GPU — это специализированный графический чип, предназначенный для ускорения создания изображений в видеоиграх и системах автоматизированного проектирования. Параллельная структура графического процессора делает его более эффективным, чем традиционный ЦП, для алгоритмов, в которых большие блоки данных обрабатываются параллельно. Графические процессоры лучше всего подходят для больших и сложных моделей данных. В основном они используются для обработки изображений, редактирования видео и игровых приложений.

Графический процессор или GPU — это специализированный графический чип, предназначенный для ускорения создания изображений в видеоиграх и системах автоматизированного проектирования. Параллельная структура графического процессора делает его более эффективным, чем традиционный ЦП, для алгоритмов, в которых большие блоки данных обрабатываются параллельно. Графические процессоры лучше всего подходят для больших и сложных моделей данных. В основном они используются для обработки изображений, редактирования видео и игровых приложений.

Графические процессоры отлично подходят для распараллеливаемых задач или задач, которые можно разбить на фрагменты, работающие независимо друг от друга. Например такие задачи, как рендеринг видео, трассировка лучей или криптография. Однако графические процессоры не идеальны для заданий, основанных на ветвлениях в коде. Ветвь — это точка принятия решения в программе о том, какой путь выбрать на основании условий.

Одной из наиболее современных тенденций во встраиваемой электронике является ПЛИС (FPGA). FPGA — это полупроводниковое устройство, которое можно запрограммировать в соответствии с конкретным задачами.

Программисты программируют чипы FPGA для выполнения множества различных операций, поэтому они используются для майнинга криптовалют — это позволяет им добывать несколько криптовалют одновременно. FPGA имеют более низкую стоимость хешрейта, чем ASIC, что делает их более прибыльными для майнеров. И в отличие от GPU, FPGA могут использовать алгоритмы SHA-256 и Scrypt.

FPGA можно перепрограммировать в полевых условиях, но они дороже, чем их конкуренты ASIC или GPU.

Как выбрать FPGA или GPU для машинного обучения?

В зависимости от потребностей вашего приложения и вычислительной среды выбор между FPGA и графическими процессорами относительно прост, когда вы принимаете решения на основе данных и оцениваете:

- Каковы ваши вычислительные требования;

- Что вписывается в ваш бюджет

Сначала давайте сравним и выделим функции GPU и FPGA, а затем решим, что лучше всего подходит для машинного обучения.

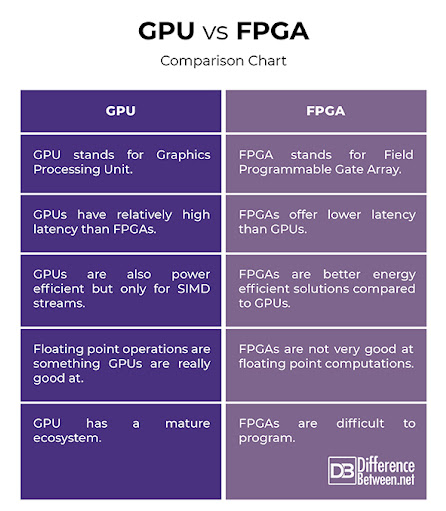

1) GPU (графический процессор) представляет собой электронную схему, предназначенную для быстрого манипулирования и изменения памяти, для ускорения создания изображений в буфере кадров, предназначенном для вывода на экран дисплея. FPGA (программируемая логическая интегральная схема) содержит массив логических вентилей, которые заказчик или разработчик может настроить под свои задачи с помощью языка описания аппаратуры (HDL).

2) По сравнению с FPGA, GPU имеет более высокую задержку. Это означает, что для обработки операции потребуется больше времени по сравнению с ПЛИС.

3) Графические процессоры лучше, чем ПЛИС, для многих приложений ИИ, таких как распознавание изображений, распознавание речи и обработка естественного языка. Однако графические процессоры не являются энергоэффективными при выполнении матричных операций, поэтому они не лучший вариант для вычислений машинного обучения с большими наборами данных. Графический процессор специально предназначен для выполнения конкретных задач, а ПЛИС предназначена для выполнения любой работы, которую вы хотите.

4) Вычислительная мощность графического процессора измеряется в гигафлопс (миллиарды операций с плавающей запятой в секунду). Обычная видеокарта среднего уровня, такая как NVIDIA GeForce GTX 1050 Ti, обеспечивает производительность 0,35 терафлопс, и это хорошо. С ПЛИС такого нет.

5) ПЛИС проектировать сложнее, чем графические процессоры. Изготовление ПЛИС более сложное; ошибка в любом месте может разрушить чип. Также сложнее отлаживать и оптимизировать код, что затрудняет масштабирование до больших размеров. Хостинг на GPU намного дешевле.

FPGA сложно программировать, поэтому они не так распространены среди любителей. Однако при необходимости их можно перепрограммировать, поэтому они популярны среди майнеров, которым может потребоваться переключение алгоритмов при появлении новой криптовалюты.

Вывод

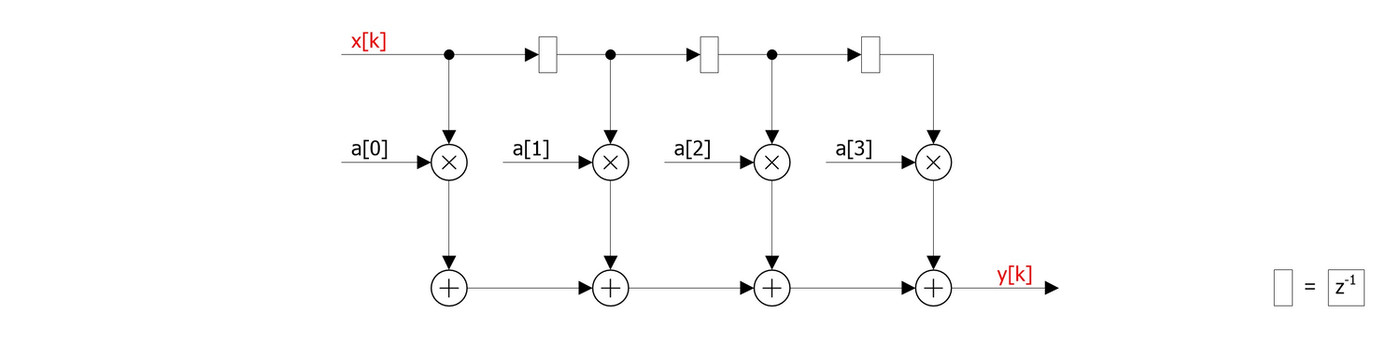

FPGA продемонстрировали большой потенциал вычислительной мощности для алгоритмов машинного обучения при разработке новых глубоких нейронных сетей. ПЛИС можно гибко использовать для реализации DNN, которые используют двоичные, троичные и иногда пользовательские типы данных. Энергоэффективность и адаптируемость к параллельной неравномерности разреженных алгоритмов DNN могут сделать FPGA отличным вариантом для приложений машинного обучения.

Оригинал статьи можно найти по ссылке.

Вы можете поддержать автора и проект по следующим реквизитам: 4100118001894658 (Юмани)